目次

『アナリティクス賢者訪問』連載の趣旨

アナリティクスに携わる人は多くいますが、それぞれに分析に対する考え方や思いは異なるもの。同連載は、アタラ合同会社コンサルタントの大友が、アナリティクス業界を牽引する著名な方々のもとを訪れ、それぞれの分析に対する考えや、魅力に感じる部分などをお聞きしています。第4回は柳井隆道さん(Option合同会社)にお話を伺いました。

今回の賢者:佐野玄さん

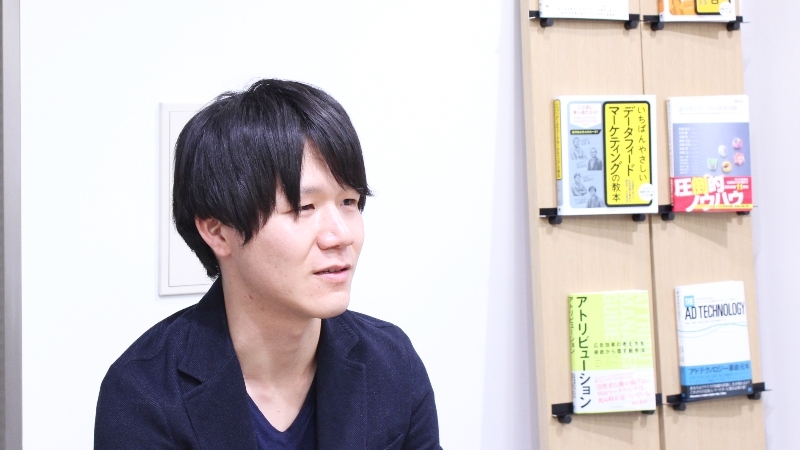

第5回となる今回は、オープンソースのリアルタイムウェブ解析ツール「Ingestly」プロジェクトをリードしている佐野玄(はじめ)さんにお話を伺います。

話し手

佐野玄(はじめ)さん

聞き手

アタラ合同会社

コンサルタント 大友直人

誰もがリアルタイムアナリティクスの環境をつくれるように

大友:前回の対談では柳井さんにインタビューをさせていただきました。柳井さんから、佐野さんはご自身でウェブ解析ツールを開発されているとお聞きしているので、本日の対談を楽しみにしています。まずは、企業概要と佐野さんのご経歴を伺えますか。

佐野:私のキャリアは、昔は“ネットマーケティング”と言われていた領域で、かれこれ18年くらいデジタルマーケティングの業界にいます。キャリアの初めのころはSEOの会社でSiteTrackerなどWebアクセス解析ツールを使用した後、ネット専業の広告代理店でテクニカルコンサルタントとして4年半、アメリカ発のウェブ解析・デジタルマーケティングスイートのベンダーでアカウントマネージャーとして6年半、国内の新聞社で3年間をデータテクノロジストとして活動していました。現在はCDPツールのベンダーでソリューションアーキテクトをしています。

前職の新聞社ではリアルタイムデータ基盤の開発をしていました。そこでは読者一人一人の閲読データを元に読者一人一人との関係値を計る「オーディエンスエンゲージメント」を重要視しており、私はリアルタイム計測の基盤やリアルタイムデータをアナリストを始め様々な部署がどれだけ迅速に扱えるかといったことに注力していました。

参考リンク:

その頃から、自社で使っているようなアナリティクス環境を誰もが扱えるようにしたいと思い、当時開発したソフトウェアの一部をオープンソース化しました。そして新聞社を退職後、2019年春にリアルタイムウェブ解析の「Ingestly」プロジェクトを開始しました。「Ingestly」はエンジニアリングスキルやエンジニアリングリソースがなくても、誰もが自前でリアルタイムアナリティクスの環境がつくれることを目指しています。

参考リンク:

大友:佐野さんがこの業界に入られた18年前は、Google アナリティクス自体もまだありませんね。

佐野:ありませんでしたね。当時はGoogle アナリティクスの前身に当たる「Urchin」という生ログを解析するツールがあり、後にGoogleに買収されてGoogle アナリティクスになりました。Googleアナリティクスには“UTM”などのパラメータがありますが、あのUってUrchinのUですね。まだUrchinの名残を感じます。

大友:そうですよね。

細かくデータを集めていた化石少年時代

大友:佐野さんがこの業界に興味を持ったきっかけは何でしょうか。

佐野:私が広義の「データ収集」や「分析」に興味を持ったのは小学生のときで、当時は化石少年だったのです。化石を掘るには山の斜面のどこにどの地層があるか知ることがすごく重要で、化石が出る地層と出ない地層があります。例えば谷の片方の標高50メートルに化石が見つかったら、必然的にもう一方の斜面の50メートルの高さに行けば同じく化石があると想像しますが、実際にはありませんでした。なぜならば、その谷ができた理由は、断層があって地盤が軟らかくなっているため水の流れによって土壌が削れるからです。つまり、どこに何があるのか、標高からだけでは判断できません。

ではどうしたらよいかというと、私がやっていたのは水質調査です。川の水を調べて、例えば石灰質が多い地層を流れるとその水はアルカリ性になるとか、どこを流れてきた水なのかが分かれば、その上流にある地質が分かります。

大友:小学生の頃からそのようなことをされていたのですね。

佐野:はい。そこで大事なことは、細かな粒度で正確なデータを集めることです。川の水質をただ調べるのではなくて、必ず川の河口側から調べる。上流から調べてしまうと、濁った水が下流に流れ自分の行動がデータに影響してしまいます。また、細かな粒度でデータを集めることによって、その地質の変化を具に把握できるので、なるべく細かく多くの地点で、サンプリングなしで正確なデータを集めるという点が、今のIngestlyに至る私のキャリアにつながっています。

大友:小学生で化石採集をしていた時代と現在の業務とでは、佐野さんの中にある“楽しい”や“ワクワクする”という気持ちは変わっていないのでしょうか。

佐野:そうですね。仮説を立てて検証することがとても楽しいですね。仮説が正しいときと外れるときがありますが、試行を重ねることで徐々に仮説の精度が上がりますし、間違っていたとしても新たな発見になり、そういった純粋な面白さがあります。

あとは、地質学に「防災」という視点があるように、収集した情報は生活者のために不可欠な情報になりえる、調査して得られたデータが社会に還元されるところに面白さを感じています。

“自分でウェブ解析ツールをつくればよい”から「Ingestly」が誕生

大友:仮説が当たっても外れても、必ず「発見」は得られるので面白いですよね。一方でアクセス解析ツールを扱う際に、難しさを感じたことはありますか。

佐野:まず現状のアクセス解析ツールについて2点お話しします。一つは世の中のアクセス解析ツールはリアルタイムに全量のデータを扱うことはあまり目指されていません。ほとんどのツールがある程度のところでデータをサンプリングしてしまったり、リアルタイムといいながらもあまり細かい分析ができず、なんとなくページビューのチャートが上下するのをリアルタイムと呼んでいることがあります。ビジネス上必要な変数の全てを1秒未満のタイムラインで扱いアクションに繋げることができるツールはほとんどないですよね。

生ログを扱うだけでも数十分、数時間、あるいは1日遅れのデータしか扱えないことが多いですし、BigQuery等に書き出さなければならない。それを扱うのも大変です。One to Oneでマーケティングしましょうとか、パーソナライズしましょうとかいっても、本当にそれができるツールは少ないです。

もう一つは、スクロールの深さや読了時間など、ページビューより細かいデータを得ようとしたとき、複数のツールを組み合わせるのが主流になっているように思います。しかしそれではツール間でデータを束ねることが非常に難しくなりますし。たくさんデータを取得しようとすれば、UXに多少の影響もあります。そこまでしてデータを取得しても本当に活用できるのかという疑問もあります。

であれば、自分で理想のウェブ解析ツールをつくる。UXに影響しない軽量なSDKで、ページビューよりも細かいデータを全量、かつリアルタイムに扱う単一のツールを作ってしまおうと思いました。

大友:それがリアルタイムウェブ解析「Ingestly」の誕生ですね。

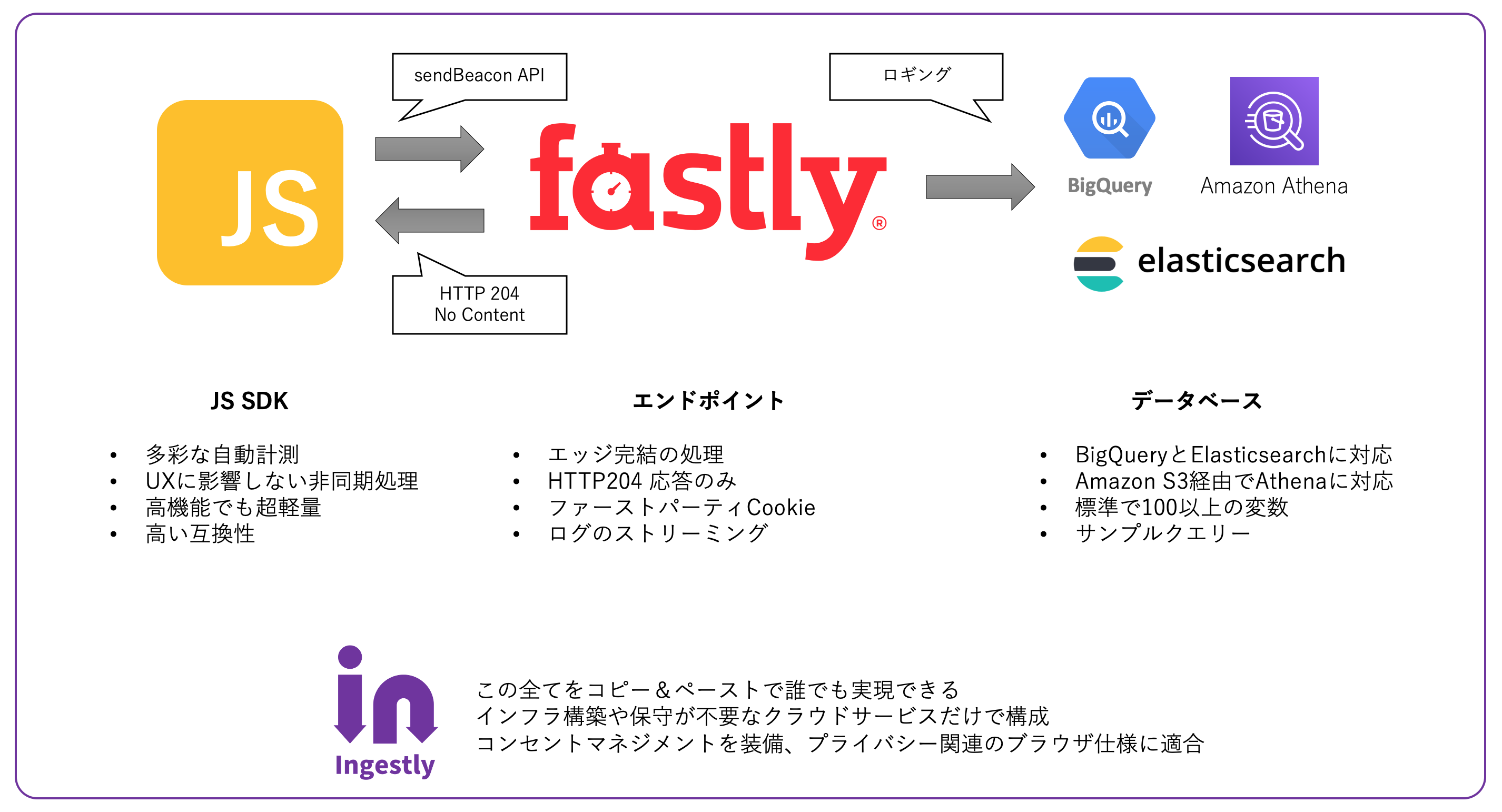

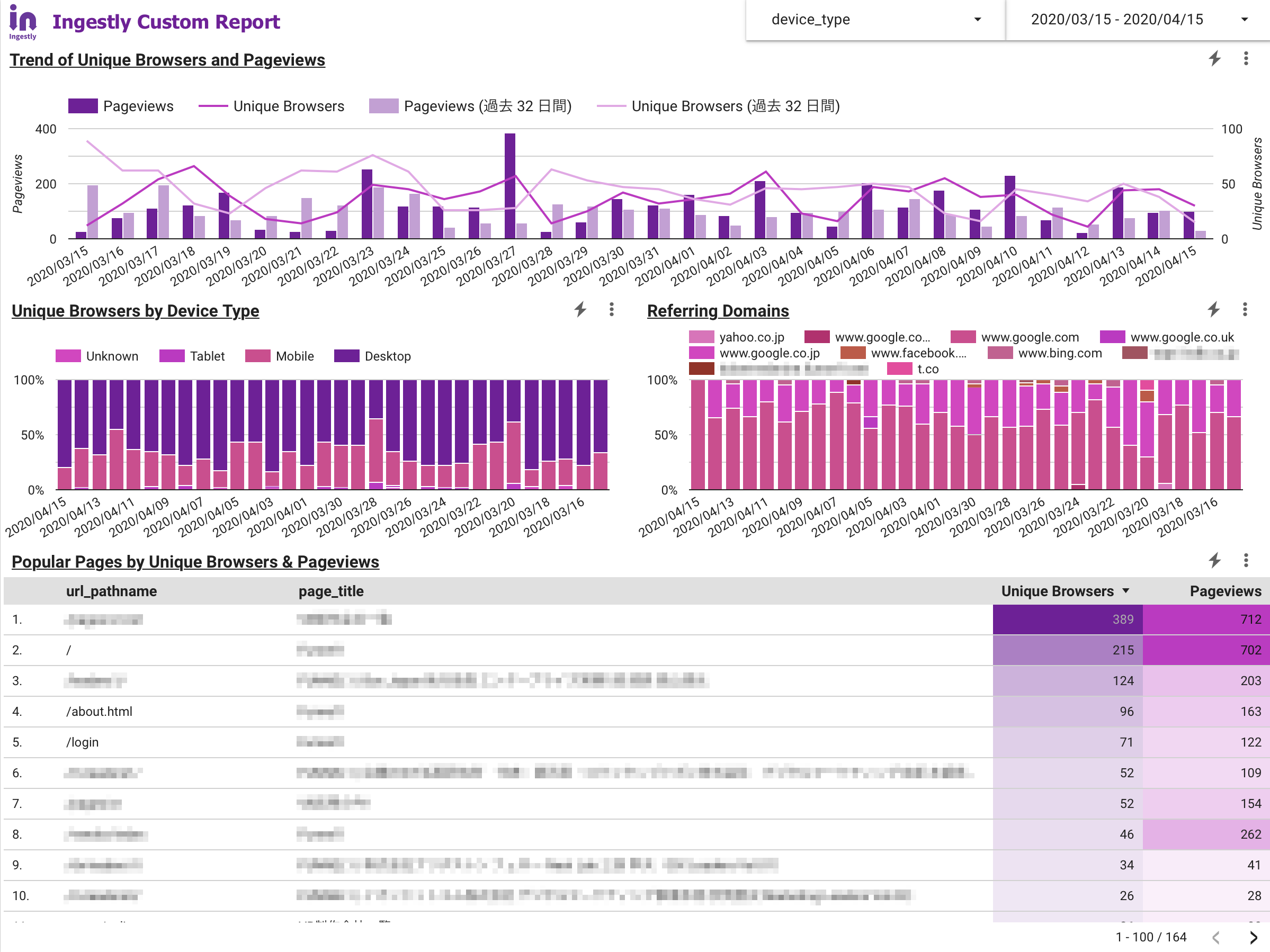

佐野:そうですね。Ingestly自体の設定は難しくなく、30分くらいで構築してデータが取得できるようになります。これはデモ画面ですが、基本的にデータを送る仕組みはGoogle アナリティクスなどと同じで、イベントが発生すると計測用のエンドポイントにデータを送ります。HTTP204というステータスコードのレスポンスを返していて、No Contentという意味でブラウザはレスポンスを待ちません。よくあるアクセス解析ツールは、レスポンスの中にいろいろな情報を混ぜて戻してくれますが、Ingestlyの場合は基本的には何も戻しません。ブラウザはレスポンスを気にせずに次々リクエストしていく仕組みを取っています。

よくある昔ながらのアクセス解析ツールの計測タグだと、document.write や appendChild を用いてHTMLの中に要素を追加してデータを送る仕組みを取りますが、それをしてしまうと頻繁にデータを送る場合にUXに影響が出ます。IngestlyはsendBeacon APIで、非同期で送られる形となり、UXにあまり影響しなくなります。

Google アナリティクスでスクロール計測をする場合はGoogle タグマネージャーを使うことが多いと思いますが、Ingestlyにはそういう仕組みが一通り内蔵されていて、タグを入れればほとんど何もせずにページビューやスクロールの指標も測れます。

大友:そもそもデータを取得する仕組みが違いますね。UIはどうでしょうか。

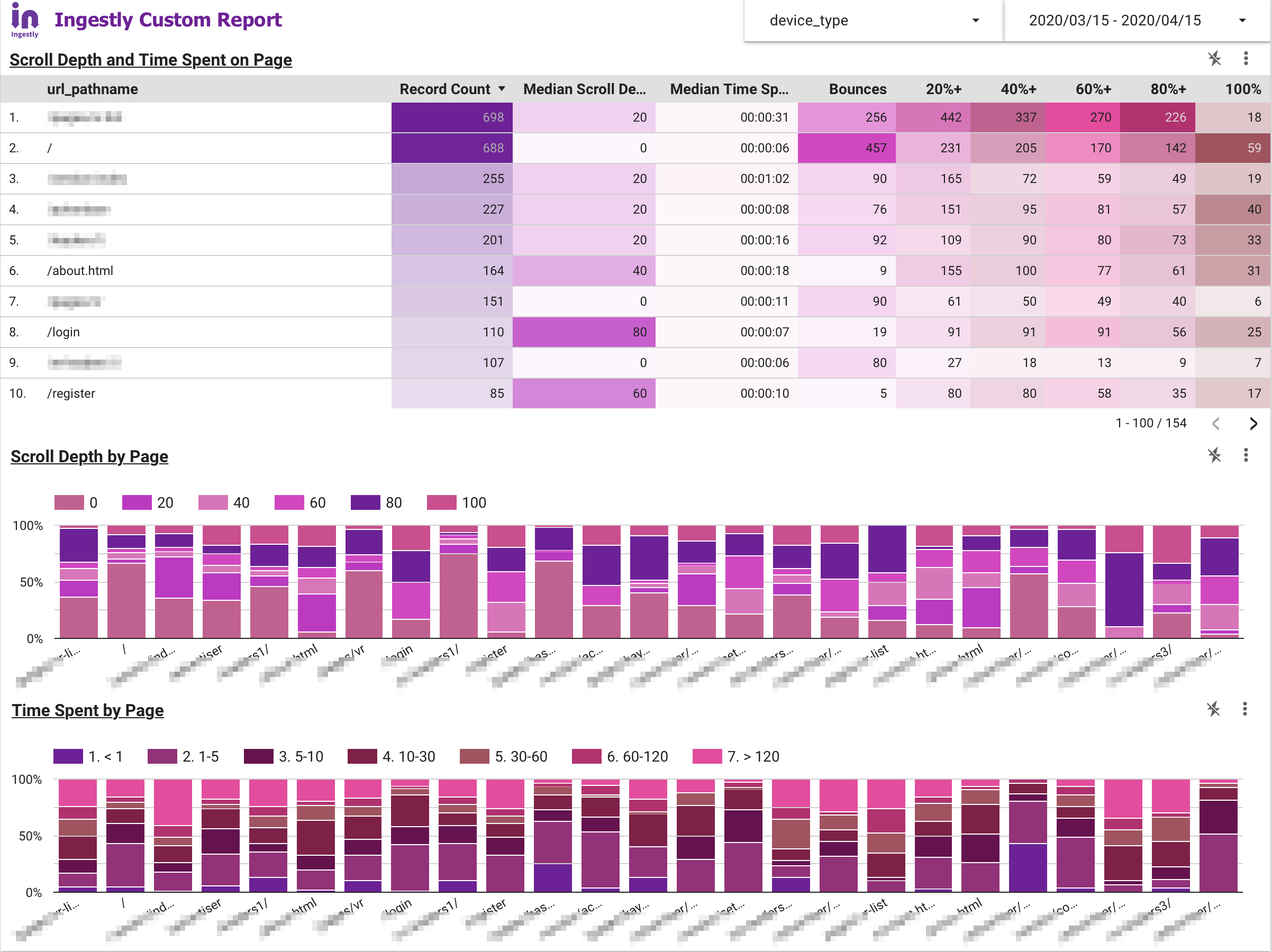

佐野:データの格納先で使えるデータベースはBigQueryのほか、Elasticsearch、Redshift、Amazon Athenaなどに対応しています。レポートとしてはこのような感じです(以下画像を参照)。データは生ログなので、日ごとのページビューなどはもちろんダッシュボードで可視化できますし、先ほどお話ししたスクロール計測はこちらです。URLのパスごとにどのくらいの深さまでスクロールされているかの中央値を集計しています。

大友:簡単にダッシュボードが作成できるわけですね。

佐野:データベースにElasticsearchを使うと、クエリーを書かずにKibanaで簡単にビジュアライズできます。Ingestlyの場合はカスタムの変数をいくらでも追加でき、自由にフィルターもできます。

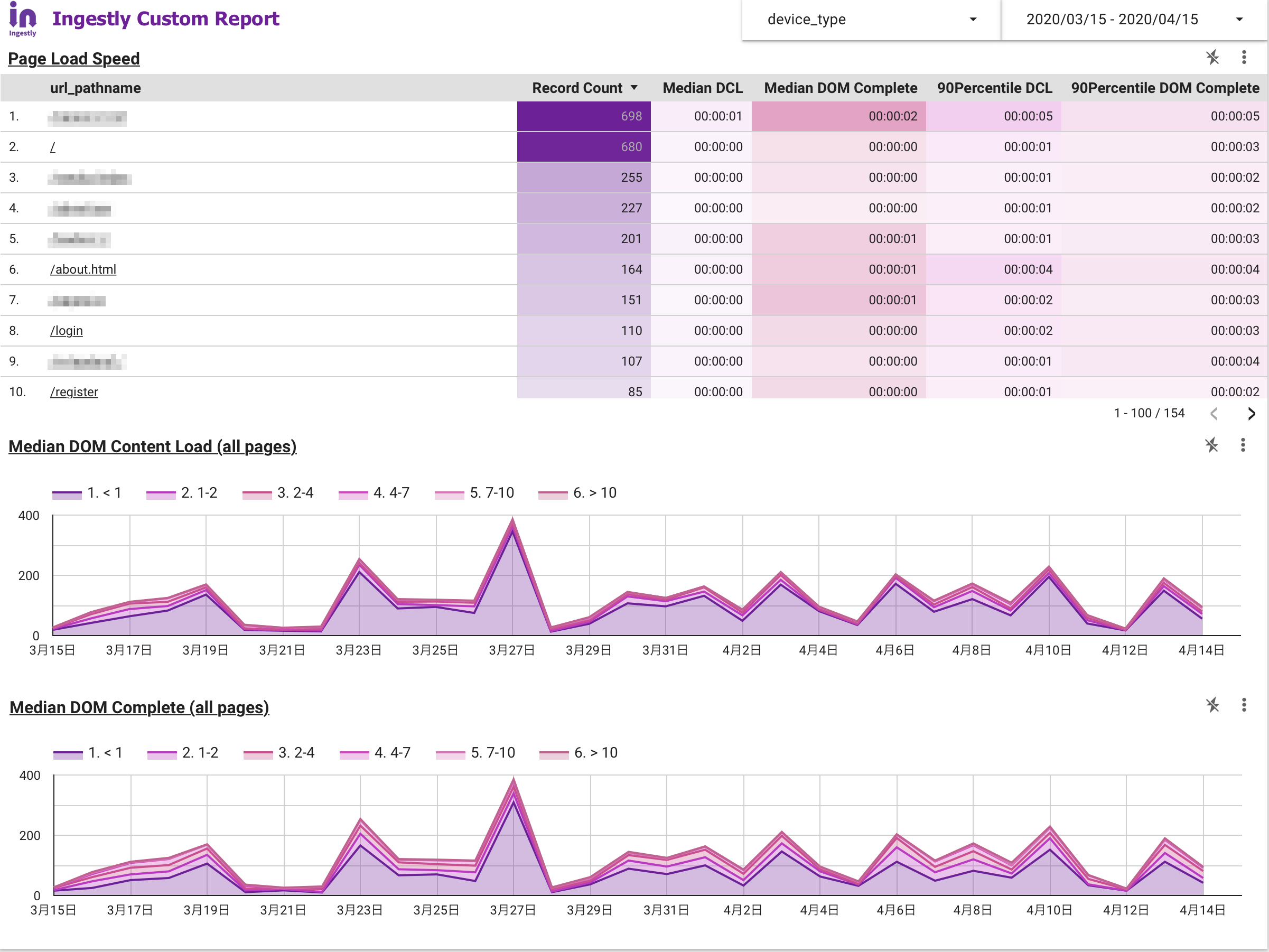

「リアルユーザーモニタリング(RUM)」はご存じでしょうか。離脱率が上がるのがページロード時間が2秒〜4秒を超えるあたりから、という前提があります。RUMではこのロード時間を実際のユーザー環境で、ページが読み込まれてからコンテンツが見えるまでに何秒かかったかを全て記録します。「このデバイス、このネットワーク、このページだとこれくらいの速度で読み込まれる」というデータを溜めていくことで、高速化が必要なページを発見したり、サイトの機能がUXに影響していないか等を評価できるようになります。ページの読み込み速度はSEOでも重要な指標です。

大友:Ingestlyは、具体的にどのような方が使用することを想定されているのでしょうか。

佐野:サイトへの訪問者を「人」としてしっかりとデータを見ていきたいというニーズがあるときに、必要とされると思います。現状のアクセス解析ツールだと「人」ごとにデータを追っていくことは難しいと思います。「人」にフォーカスして細かくコミュニケーション履歴を追いたいというニーズがある人たちに使われているイメージです。

大友:Ingestlyは生ログをBigQueryなどに格納しますが、Google アナリティクスも「アプリ+ウェブ プロパティ」が登場して、前回の対談では柳井さんが「BigQueryを使って分析することを前提にシステムを組んでいるのではないか」とおっしゃっていました。

佐野:これからは似たような、例えばImply(https://imply.io)のようなストリームデータ処理と分析を組み合わせたサービスが増えるのかなと思っています。Firebaseは、ストリームデータ処理に長けていて、そこにデータを入れる方法がうまく構築されてきているので、ウェブとSDKが統合されていくようになると思います。今はそういう流れなのかなと思います。

大友:今はプライバシーやデータ取得制限の話題でいっぱいですが、私たちに求められることは何でしょうか。

佐野:今はチャレンジングなタイミングですね。プライバシーの問題やブラウザの制約が増えているので、技術的にも組織的にも「人」のデータをどう扱っていくかを安全に仕組み化する段階に来ていると思います。自分たちのビジネスを最適化するためのデータとしてではなく、顧客価値を創るためのデータですよといえるような、価値を共創する視点でデータ活用の道筋をつけることが求められていると思います。その上で、ユーザーにしっかりとデータを取得することに対して同意を得る、コンセントマネジメントをするということが必要なのではないでしょうか。

データとは「組織の血液」

大友:毎回皆さんに「データとは」「分析とは」について伺っています。佐野さんにとってデータとは、分析とは何でしょうか。

佐野:データは「組織の血液」に当たるものかなと思っています。血液は、体内で必要なものを運んでくれて、絶えず流れるものですよね。常に生まれて常に失っていくみたいなところで、データも似通ったところがあります。ストリームデータなどはまさに“流れ”なのですが、新しいことをやれば、新しい情報や価値が組織内に流通していくと思います。データをうまく組織内で回していく、循環させる、あるいはクリーンでヘルシーに保つということがすごく大事な視点で、それが組織におけるデータだと考えています。

大友:データは「組織の血液」ですか。では分析とは何でしょうか。

佐野:分析は、機会を見つけるための一つの手段であり、顧客との接点をしっかりと振り返る一つの方法だと思います。なので、分析という行動が施策の起点になることはあまりなくて、目指している方向性や期待値があって、その到達点と現状とのギャップを見つけるための手段が分析だと思います。私はあまりデータドリブンとはいわず「オブジェクティブドリブン」というのですが、目的があってこそのデータ活用なのかなと。目的に沿ってドライブするためにデータがあり、分析をしていくものだと考えています。

大友:目的や仮説がない状態で「分析」をしても何もアウトプットは得られませんよね。Unyoo.jpの読者の方にメッセージもお願いします。

佐野:どの組織でもデータ活用を進めていこうとすると、あるところで既製品に対するストレスが限界に達してしまうと思うので、目的に応じて柔軟にツールを選べるようになったらよいのではないかと思います。そのときはどんなツールがスペック表の上で優れているのかではなく、自分たちはどういうデータがあれば何ができるのか、顧客にどういう価値を提供できるのか、あるいは組織をどう動かすことができるのかという視点で、最適なツールを見つけることが重要だと思います。

大友:同連載は今回インタビューさせていただいた方に「分析についての考えを聞いてみたい!」と思う方を教えていただき、私がインタビューに伺うという、リレー形式の連載になります。佐野さんが、分析について聞いてみたい方はどなたでしょうか。

佐野:過去にお客様でもあり、

大友:大変貴重なお話を、ありがとうございました。

バックナンバー: